Paul Barbaste (M.21), en pleine neuro science-fiction

Après avoir contrôlé des robots par la pensée et programmé des algorithmes sur le dark web, Paul Barbaste (M.21) travaille sur une technologie permettant aux personnes tétraplégiques de commander des objets à distance grâce à de nouveaux modèles d’intelligence artificielle générative. Entretien avec une tête qui fourmille.

Aux côtés du neuroscientifique Olivier Oullier, Paul Barbaste, a mis au point une interface cerveau-machine qui permet aux objets et environnements connectés – qu’il s’agisse d’une station de travail, d’un téléphone ou de la réalité augmentée – de s‘adapter à ses utilisateurs, voire d’être contrôlés uniquement par la pensée. Télékinésie ? Science-fiction ? Non, plusieurs intelligences artificielles à l’œuvre, des mois de recherche, et une alliance entre l’expérience des grands noms du milieu et l’esprit entrepreneurial d’un jeune inventeur de 27 ans.

De Gotham à Star Wars

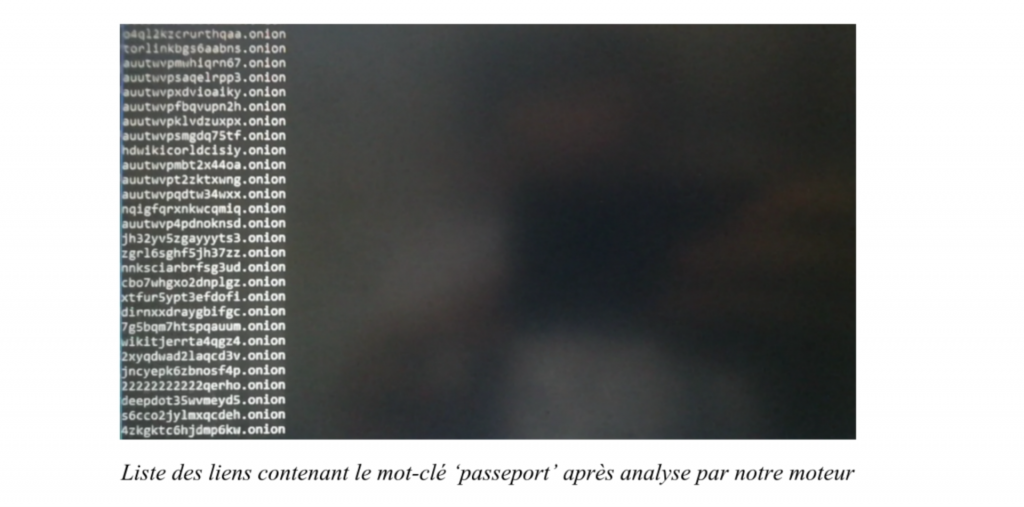

« Ma mère aime à raconter que j’ai commencé à jouer avec un ordinateur avant de savoir lire », raconte volontiers Paul Barbaste, dont l’intérêt pour la programmation informatique apparaît très tôt. Bien que né au sein d’une famille d’ingénieurs, aux grandes écoles d’ingé il préfèrera commencer à étudier à Science Po Strasbourg. En parallèle de ses études, il trouve un travail dans la cybersécurité en tant qu’analyste, et passe des journées entières du côté obscur de l’internet. « Le dark web est un espace aussi dérégulé que désorganisé. Il faut garder en tête qu’il n’y a pas de moteur de recherche pour y naviguer », explique-t-il.

Lassé de brasser un contenu parfois avilissant au quotidien, il programme son propre algorithme pour faire remonter et interpréter l’information, se basant sur le Natural Language Processing (NLP), « une forme de précurseur de l’IA qui est actuellement au cœur de ChatGPT ». Un outil de recherche qu’il nomme Gotham. Avec un collègue, il créé également le « projet Richelieu », qui regroupe une liste des 20 000 mots de passe français les plus utilisés et est disponible sur la plateforme plébiscitée par les développeurs web, GitHub.

Terminal de « Gotham », le moteur de recherche pour le dark web conçu par Paul Barbaste.

En 2018, l’étudiant fan de science-fiction – et de Star Wars en particulier – tombe sur la vidéo d’un jeune brésilien tétraplégique, Rodrigo Hübner Mendes, pilotant une Formule 1 par la pensée grâce à une interface cerveau-machine (ICM). Ce dernier est équipé de capteurs d’activité cérébrale commercialisés par l’entreprise californienne Emotiv, leader mondial dans la neurotech, dont Olivier Oullier, le futur associé de Paul, est alors président. Les ICM deviennent une obsession pour Paul. Il en parle à ses collègues ingénieurs en cybersécurité qui lui conseillent… de laisser tomber. Leur argument ? “Tu n’es pas ingénieur”.

« Je n’ai pas eu envie d’arrêter de rêver »

Paul Barbaste, alors étudiant, développant un programme pour diriger un robot par la pensée via un casque à électroencephalogramme. Photo©DNA/Michel Frison

Le futur entrepreneur se lance pourtant dans un projet baptisé Jedi qui permet de contrôler par la pensée un petit drone BB8, élément de la saga Star Wars. Capter l’activité cérébrale et l’interpréter avec un algorithme via une interface lui permet de différencier un état neutre de l’envoi d’une commande mentale. « J’ai mis deux ans et demi avant de sortir un premier prototype à moitié fonctionnel, explique Paul Barbaste. Cela coïncidait avec la sortie du dernier film de la saga des Skywalker ». Son projet attire l’attention de la presse locale et des journalistes du JT de M6.

« Je n’ai pas eu envie d’arrêter de rêver, confie le jeune homme. Médecins, commerçants, ingénieurs…. La société française est structurée sous forme de castes. C’est compliqué d’avoir des hybrides. » Il voit cependant dans le Master X-Entrepreneur commun à HEC et à l’École Polytechnique une opportunité pour diriger son projet vers l’entrepreneuriat et creuser l’ingénierie du domaine de l’intelligence artificielle. Il noue, pendant sa première année, un contact avec le neuroscientifique de la vidéo, Olivier Oullier, ancien membre du Comex du Forum économique mondial où il a dirigé la stratégie en santé et systèmes de soins.

Le marché des interfaces cerveau-machine a vu une accélération des acquisitions et des investissements par les Gafam au cours des cinq dernières années. En 2023, Apple et Meta ont publié des brevets pour des écouteurs équipés d’électrodes capables d’enregistrer l’activité du cerveau.

Nous arrivons à maturité sur le développement de notre modèle d’intelligence artificielle qui est capable de détecter une commande mentale.

Mais l’usage de ces objets à la pointe de la tech se cantonne pour l’instant aux recherches scientifiques et cliniques, au neuromarketing et au gaming. « Dans quasiment toutes les montres connectées, vous avez déjà des capteurs qui permettent d’enregistrer l’activité cardiaque. Les nouveaux casques de réalité virtuelle d’Apple et de Meta comportent des capteurs de mouvements des yeux, énumère Paul Barbaste. La prochaine étape sera l’intégration à grande échelle des capteurs d’activité cérébrale. Cela fera partie du futur des interactions de l’humain avec la machine. »

Des innovations pour les personnes en situation de handicap

Le projet de l’entrepreneur est de rendre ses innovations « accessibles au plus grand nombre » et de « servir le bien commun. » En 2022, Paul Barbaste et Olivier Oullier fondent Inclusive Brains pour proposer des interfaces cerveau-machine permettant aux personnes en situation de handicap moteur de plus facilement s’insérer dans le monde du travail. Bénéficiant de l’aide du TechLab de l’Association des Paralysés de France, ils ont l’opportunité de pouvoir échanger avec des tétraplégiques ne pouvant communiquer qu’à travers des clignements d’yeux. « Très peu sont outillés, précise Paul, qui est aussi responsable d’une formation sur la neuroscience et la neurotechnologie à l’École Polytechnique. De nombreuses innovations sont passées par le handicap. Graham Bell aurait bossé sur les premiers prototypes de téléphone pour aider sa maman qui était malentendante. La télécommande a été inventée pour des personnes incapables de se déplacer. »

Paul Barbaste activant un bras robotique via un casque à électrodes.

Ils mettent actuellement au point une intelligence artificielle générative qui permet de transformer des mesures neurophysiologiques en commandes pour contrôler un ordinateur sans avoir besoin de bouger, de toucher ou de parler. « Les IA comme ChatGPT sont des modèles de langage qui ne sont entraînés qu’avec du texte. Or, tout ne passe pas que par le langage. Notre IA générative est entraînée avec des ondes cérébrales et des données physiologiques pour se rapprocher au plus près du fonctionnement des humains, détaille Paul Barbaste. Ensuite, nos modèles analysent et classifient ces informations pour détecter en temps réel les variations d’attention ou de charge mentale, par exemple. »

Inclusive Brains s’est développée avec un soutien de business angels et de Bpi France, et n’a pour l’instant pas eu besoin de réaliser de grosse levée de fonds. Fin 2023, Inclusive Brains a été récompensée à deux reprises aux Handitech Trophy de la BPI, l’un des prix ayant été remis par la ministre de l’Enseignement supérieur et de la Recherche Sylvie Retailleau. Partiellement installée à l’Incubateur HEC, participante du programme HEC Creative Destruction Lab (CDL) de l’Innovation & Entrepreneurship Institute sur la deep tech, la start-up fait partie des Future 40 de la Station F et est accompagnée par la Fondation CMA-CGM. Les deux cofondateurs visent, à terme, un usage de leur technologie élargi à tous avec la volonté d’améliorer la santé et la sécurité dans les environnements de travail.

Published by Estel Plagué